Une performance fluide est essentielle pour créer des expériences de jeu immersives pour les joueurs. Pour garantir que votre jeu est optimisé, un flux de travail de profilage cohérent de bout en bout est un "must have" pour un développement de jeu efficace, et cela commence par une procédure simple en trois points :

Cette page décrit un flux de travail général de profilage pour les développeurs de jeux. Il est extrait de l'e-book, Guide ultime du profilage des jeux Unity, disponible en téléchargement gratuit (la version Unity 6 du guide sera bientôt disponible). L'e-book a été créé par des experts Unity externes et internes en développement de jeux, profilage et optimisation.

Dans cet article, vous pouvez apprendre des objectifs utiles à définir avec le profilage, des goulets d'étranglement de performance courants, tels que la dépendance au CPU ou au GPU, et comment identifier et examiner ces situations plus en détail.

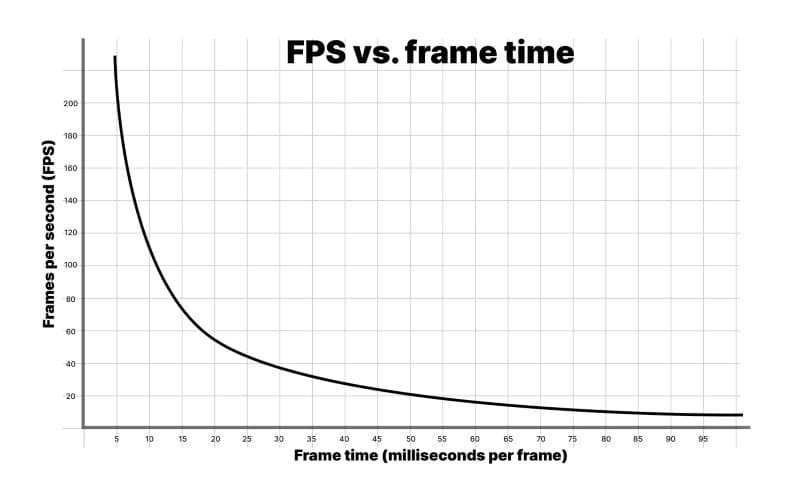

Les joueurs mesurent souvent la performance en utilisant le taux de rafraîchissement, ou les images par seconde (fps), mais en tant que développeur, il est généralement recommandé d'utiliser le temps de trame en millisecondes à la place. Considérez le scénario simplifié suivant :

Pendant l'exécution, votre jeu rend 59 images en 0,75 seconde. Cependant, la prochaine image prend 0,25 seconde à rendre. Le taux de rafraîchissement moyen de 60 fps semble bon, mais en réalité, les joueurs remarqueront un effet de saccade puisque la dernière image prend un quart de seconde à rendre.

C'est l'une des raisons pour lesquelles il est important de viser un budget de temps spécifique par image. Cela vous fournit un objectif solide à atteindre lors du profilage et de l'optimisation de votre jeu, et finalement, cela crée une expérience plus fluide et plus cohérente pour vos joueurs.

Chaque image aura un budget de temps basé sur votre fps cible. Une application visant 30 fps devrait toujours prendre moins de 33,33 ms par image (1000 ms / 30 fps). De même, un objectif de 60 fps laisse 16,66 ms par image (1000 ms / 60 fps).

Vous pouvez dépasser ce budget pendant des séquences non interactives, par exemple, lors de l'affichage de menus UI ou du chargement de scènes, mais pas pendant le gameplay. Même une seule image qui dépasse le budget de trame cible provoquera des saccades.

Remarque : Un taux de rafraîchissement constamment élevé dans les jeux VR est essentiel pour éviter de provoquer des nausées ou de l'inconfort chez les joueurs, et est souvent nécessaire pour que votre jeu obtienne la certification du détenteur de la plateforme.

Images par seconde : Une métrique trompeuse

Une façon courante pour les joueurs de mesurer la performance est avec le taux de rafraîchissement, ou les images par seconde. Cependant, il est recommandé d'utiliser le temps de trame en millisecondes à la place. Pour comprendre pourquoi, regardez le graphique ci-dessus des fps par rapport au temps de trame.

Considérez ces chiffres :

1000 ms/sec / 900 fps = 1,111 ms par image

1000 ms/sec / 450 fps = 2,222 ms par image

1000 ms/sec / 60 fps = 16,666 ms par image

1000 ms/sec / 56,25 fps = 17,777 ms par image

Si votre application fonctionne à 900 fps, cela se traduit par un temps d'image de 1,111 millisecondes par image. À 450 fps, cela représente 2,222 millisecondes par image. Cela représente une différence de seulement 1,111 millisecondes par image, même si le taux de rafraîchissement semble diminuer de moitié.

Si vous regardez les différences entre 60 fps et 56,25 fps, cela se traduit respectivement par 16,666 millisecondes par image et 17,777 millisecondes par image. Cela représente également 1,111 millisecondes supplémentaires par image, mais ici, la baisse du taux de rafraîchissement semble beaucoup moins dramatique en pourcentage.

C'est pourquoi les développeurs utilisent le temps moyen d'image pour évaluer la vitesse du jeu plutôt que le fps.

Ne vous inquiétez pas du fps à moins que vous ne tombiez en dessous de votre taux de rafraîchissement cible. Concentrez-vous sur le temps d'image pour mesurer la rapidité de votre jeu, puis restez dans votre budget d'images.

Lisez l'article original, "Robert Dunlop’s fps versus frame time," pour plus d'informations.

Le contrôle thermique est l'un des domaines les plus importants à optimiser lors du développement d'applications pour appareils mobiles. Si le CPU ou le GPU passent trop de temps à pleine puissance en raison d'un code inefficace, ces puces vont chauffer. Pour éviter la surchauffe et les dommages potentiels aux puces, le système d'exploitation réduira la vitesse d'horloge de l'appareil pour lui permettre de refroidir, ce qui provoque des saccades d'image et une mauvaise expérience utilisateur. Cette réduction de performance est connue sous le nom de throttling thermique.

Des taux de rafraîchissement plus élevés et une exécution de code accrue (ou des opérations d'accès DRAM) entraînent une augmentation de la consommation de batterie et de la génération de chaleur. Une mauvaise performance peut également rendre votre jeu injouable pour des segments entiers d'appareils mobiles bas de gamme, ce qui peut entraîner des occasions de marché manquées.

Lors de la prise en charge du problème des thermiques, considérez le budget dont vous disposez comme un budget global du système.

Combattez le throttling thermique et la décharge de la batterie en profilant tôt pour optimiser votre jeu dès le départ. Ajustez vos paramètres de projet pour le matériel de votre plateforme cible afin de lutter contre les problèmes de thermique et de décharge de la batterie.

Ajoutez des budgets de trame sur mobile

Un conseil général pour lutter contre les problèmes thermiques des appareils lors de longues sessions de jeu est de laisser un temps d'inactivité de trame d'environ 35%. Cela donne aux puces mobiles le temps de refroidir et aide à prévenir une décharge excessive de la batterie. En utilisant un temps de trame cible de 33,33 ms par trame (pour 30 fps), le budget de trame pour les appareils mobiles sera d'environ 22 ms par trame.

Le calcul ressemble à ceci : (1000 ms / 30) * 0.65 = 21.66 ms

Pour atteindre 60 fps sur mobile en utilisant le même calcul, il faudrait un temps de trame cible de (1000 ms / 60) * 0.65 = 10.83 ms. C'est difficile à atteindre sur de nombreux appareils mobiles et cela déchargerait la batterie deux fois plus vite que de viser 30 fps. Pour ces raisons, de nombreux jeux mobiles visent 30 fps plutôt que 60. Utilisez Application.targetFrameRate pour contrôler ce paramètre, et référez-vous à la section "Définir un budget de trame" dans l'e-book de profilage pour plus de détails sur le temps de trame.

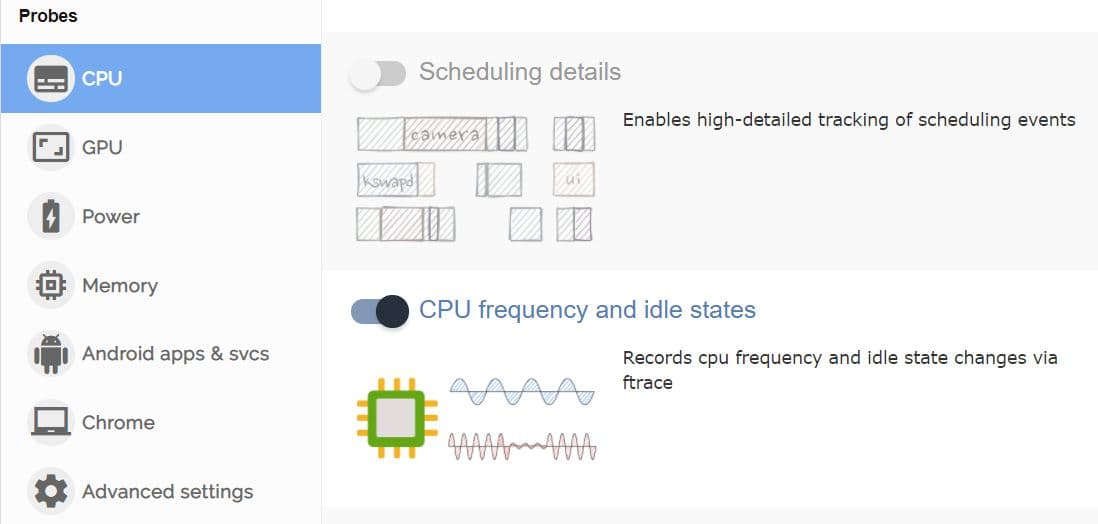

L'échelle de fréquence sur les puces mobiles peut rendre difficile l'identification de vos allocations de budget de temps d'inactivité de trame lors du profilage. Vos améliorations et optimisations peuvent avoir un effet net positif, mais l'appareil mobile pourrait réduire la fréquence, et par conséquent, fonctionner plus frais. Utilisez des outils personnalisés tels que FTrace ou Perfetto pour surveiller les fréquences des puces mobiles, le temps d'inactivité et l'échelle avant et après les optimisations.

Tant que vous restez dans votre budget total de temps de trame pour votre fps cible (disons 33,33 ms pour 30 fps) et que vous voyez votre appareil travailler moins ou enregistrer des températures plus basses pour maintenir ce taux de trame, alors vous êtes sur la bonne voie.

Une autre raison d'ajouter de la marge au budget de trame sur les appareils mobiles est de tenir compte des fluctuations de température dans le monde réel. Par une journée chaude, un appareil mobile va chauffer et avoir du mal à dissiper la chaleur, ce qui peut entraîner un throttling thermique et une mauvaise performance du jeu. Réservez un pourcentage du budget de trame pour aider à éviter ce scénario.

L'accès DRAM est généralement une opération gourmande en énergie sur les appareils mobiles. Les conseils d'optimisation d'Arm pour le contenu graphique sur les appareils mobiles indiquent que l'accès à la mémoire LPDDR4 coûte environ 100 picojoules par octet.

Réduisez le nombre d'opérations d'accès à la mémoire par image en :

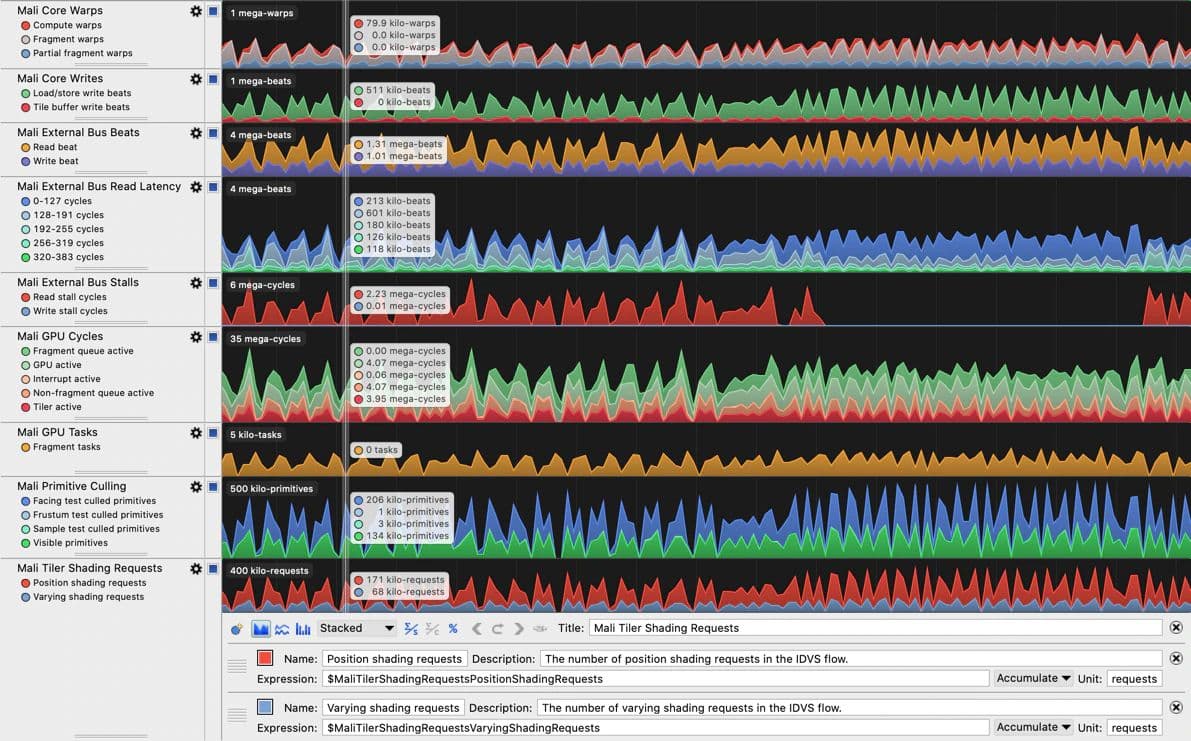

Lorsque vous devez vous concentrer sur les appareils utilisant le matériel CPU ou GPU d'Arm, l'outil Arm Performance Studio (en particulier, Streamline Performance Analyzer) comprend d'excellents compteurs de performance pour identifier les problèmes de bande passante mémoire. Les compteurs disponibles sont listés et expliqués pour chaque génération de GPU Arm dans un guide utilisateur correspondant, par exemple, Guide de référence des compteurs de performance Mali-G710. Notez que le profilage GPU d'Arm Performance Studio nécessite un GPU Arm Immortalis ou Mali.

Établir des niveaux de matériel pour le benchmarking

En plus d'utiliser des outils de profilage spécifiques à la plateforme, établissez des niveaux ou un appareil de spécifications minimales pour chaque plateforme et niveau de qualité que vous souhaitez prendre en charge, puis profilez et optimisez les performances pour chacune de ces spécifications.

Par exemple, si vous ciblez des plateformes mobiles, vous pourriez décider de prendre en charge trois niveaux avec des contrôles de qualité qui activent ou désactivent des fonctionnalités en fonction du matériel cible. Vous optimisez ensuite pour la spécification d'appareil la plus basse dans chaque niveau. Comme autre exemple, si vous développez un jeu pour consoles, assurez-vous de profiler à la fois sur les versions plus anciennes et plus récentes.

Notre dernier guide d'optimisation mobile contient de nombreux conseils et astuces qui vous aideront à réduire le throttling thermique et à augmenter la durée de vie de la batterie des appareils mobiles exécutant vos jeux.

Lors du profilage, vous devez vous assurer de concentrer votre temps et vos efforts sur les domaines où vous pouvez créer le plus grand impact. Il est donc recommandé de commencer par une approche de haut en bas lors du profilage, ce qui signifie que vous commencez par un aperçu général des catégories telles que le rendu, les scripts, la physique et les allocations de collecte des ordures (GC). Une fois que vous avez identifié les domaines de préoccupation, vous pouvez approfondir les détails. Utilisez ce passage de haut niveau pour collecter des données et prendre des notes sur les problèmes de performance les plus critiques, y compris les scénarios qui causent des allocations gérées indésirables ou une utilisation excessive du CPU dans votre boucle de jeu principale.

Vous devrez d'abord rassembler les piles d'appels pour les marqueurs GC.Alloc. Si vous n'êtes pas familier avec ce processus, trouvez quelques conseils et astuces dans la section intitulée "Localiser les allocations de mémoire récurrentes sur la durée de vie de l'application" dans l'e-book.

Si les piles d'appels signalées ne sont pas suffisamment détaillées pour identifier la source des allocations ou d'autres ralentissements, vous pouvez effectuer une deuxième session de profilage avec le Profilage Profond activé afin de trouver la source des allocations. Nous couvrons le profilage profond en détail dans l'e-book, mais en résumé, c'est un mode dans le Profiler qui capture des données de performance détaillées pour chaque appel de fonction, fournissant des informations granulaires sur les temps d'exécution et les comportements, mais avec un surcoût significativement plus élevé par rapport au profilage standard.

Lorsque vous collectez des notes sur les "offenseurs" du temps de trame, assurez-vous de noter comment ils se comparent par rapport au reste de la trame. Cet impact relatif peut être déformé lorsque le profilage profond est activé, car le profilage profond ajoute un surcoût significatif en instrumentant chaque appel de méthode.

Profilage précoce

Bien que vous deviez toujours profiler tout au long du cycle de développement de votre projet, les gains les plus significatifs du profilage se font lorsque vous commencez dans les phases précoces.

Profilez tôt et souvent afin que vous et votre équipe compreniez et mémorisiez une "signature de performance" pour le projet que vous pouvez utiliser comme référence. Si la performance chute, vous pourrez facilement repérer quand les choses tournent mal et corriger le problème.

Bien que le profilage dans l'Éditeur vous donne un moyen facile d'identifier les principaux problèmes, les résultats de profilage les plus précis proviennent toujours de l'exécution et du profilage des builds sur des appareils cibles, en utilisant des outils spécifiques à la plateforme pour explorer les caractéristiques matérielles de chaque plateforme. Cette combinaison vous fournira une vue holistique de la performance de l'application sur tous vos appareils cibles. Par exemple, vous pourriez être limité par le GPU sur certains appareils mobiles mais limité par le CPU sur d'autres, et vous ne pouvez apprendre cela qu'en mesurant sur ces appareils.

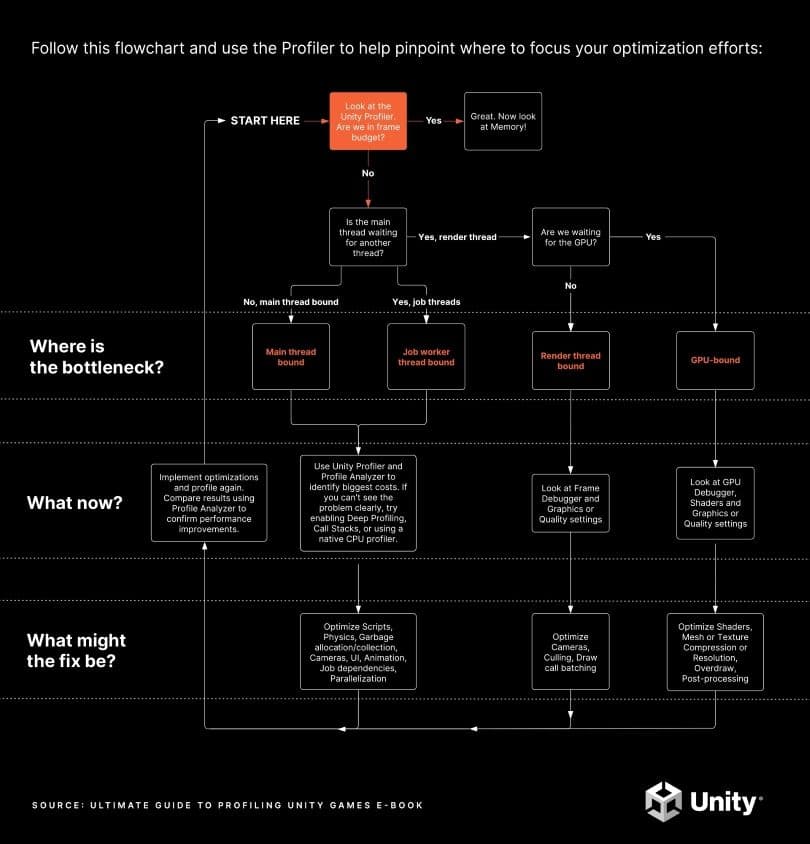

Téléchargez la version PDF imprimable de ce tableau ici.

Le but du profilage est d'identifier les goulets d'étranglement comme cibles pour l'optimisation. Si vous vous fiez à des suppositions, vous risquez d'optimiser des parties du jeu qui ne sont pas des goulets d'étranglement, ce qui entraîne peu ou pas d'amélioration de la performance globale. Certaines "optimisations" pourraient même aggraver la performance globale de votre jeu tandis que d'autres peuvent être laborieuses mais donner des résultats insignifiants. La clé est d'optimiser l'impact de votre investissement de temps ciblé.

Le diagramme ci-dessus illustre le processus de profilage initial avec les sections qui le suivent fournissant des informations détaillées sur chaque étape. Ils présentent également des captures de Profiler provenant de projets Unity réels pour illustrer les types de choses à rechercher.

Pour obtenir une vue d'ensemble de toute l'activité CPU, y compris lorsqu'elle attend le GPU, utilisez la vue de la chronologie dans le module CPU du Profiler. Familiarisez-vous avec les marqueurs Profiler courants pour interpréter correctement les captures. Certains des marqueurs Profiler peuvent apparaître différemment selon votre plateforme cible, alors passez du temps à explorer les captures de votre jeu sur chacune de vos plateformes cibles pour vous faire une idée de ce à quoi ressemble une capture « normale » pour votre projet.

La performance d'un projet est limitée par la puce et/ou le thread qui prend le plus de temps. C'est la zone sur laquelle les efforts d'optimisation devraient se concentrer. Par exemple, imaginez les scénarios suivants pour un jeu avec un budget de temps d'image cible de 33,33 ms et VSync activé :

Consultez ces ressources qui explorent davantage le fait d'être limité par le CPU ou le GPU :

Profiler et optimiser votre projet tôt et souvent tout au long du développement vous aidera à vous assurer que tous les threads CPU de votre application et le temps d'image global du GPU sont dans le budget d'image. La question qui guidera ce processus est, êtes-vous dans le budget d'image ou non ?

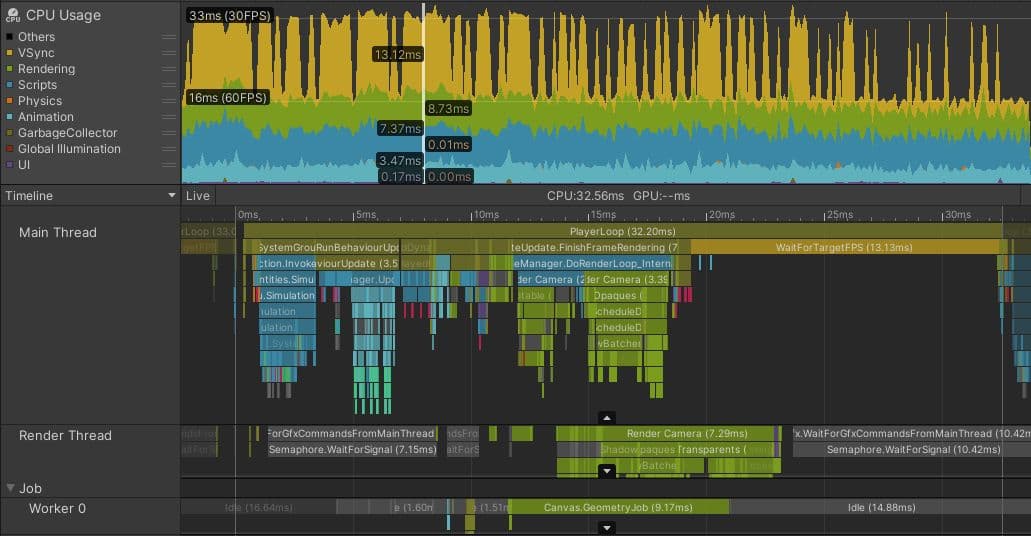

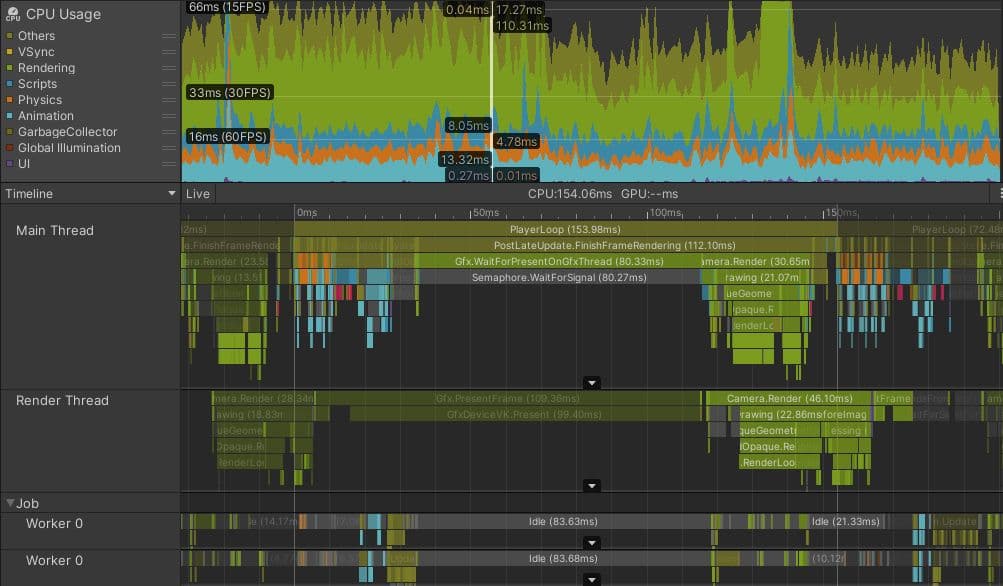

Ci-dessus se trouve une image d'une capture de profil d'un jeu mobile Unity développé par une équipe qui a effectué un profilage et une optimisation continus. Le jeu cible 60 FPS sur des téléphones mobiles haut de gamme et 30 FPS sur des téléphones de milieu/bas de gamme, comme celui de cette capture.

Notez comment près de la moitié du temps sur la trame sélectionnée est occupée par le marqueur Profiler jaune WaitForTargetFPS. L'application a défini Application.targetFrameRate à 30 FPS, et VSync est activé. Le travail de traitement réel sur le thread principal se termine autour de la marque de 19 ms, et le reste du temps est passé à attendre que le reste des 33,33 ms s'écoule avant de commencer la prochaine trame. Bien que ce temps soit représenté par un marqueur Profiler, le thread principal du CPU est essentiellement inactif pendant ce temps, permettant au CPU de refroidir et d'utiliser un minimum d'énergie de la batterie.

Le marqueur à surveiller peut être différent sur d'autres plateformes ou si VSync est désactivé. L'important est de vérifier si le thread principal fonctionne dans votre budget de trame ou exactement sur votre budget de trame avec une sorte de marqueur qui indique que l'application attend VSync et si les autres threads ont du temps d'inactivité.

Le temps d'inactivité est représenté par des marqueurs Profiler gris ou jaunes. La capture d'écran ci-dessus montre que le thread de rendu est inactif dans Gfx.WaitForGfxCommandsFromMainThread, ce qui indique les moments où il a fini d'envoyer des appels de dessin au GPU sur une trame, et attend plus de demandes d'appels de dessin du CPU sur la suivante. De même, bien que le thread Job Worker 0 passe un certain temps dans Canvas.GeometryJob, la plupart du temps il est inactif. Ce sont tous des signes d'une application qui est confortablement dans le budget de trame.

Si votre jeu est dans le budget de trame

Si vous êtes dans le budget de trame, y compris tout ajustement effectué au budget pour tenir compte de l'utilisation de la batterie et du throttling thermique, vous avez terminé les tâches de profilage clés. Vous pouvez conclure en exécutant le Memory Profiler pour vous assurer que l'application est également dans son budget mémoire.

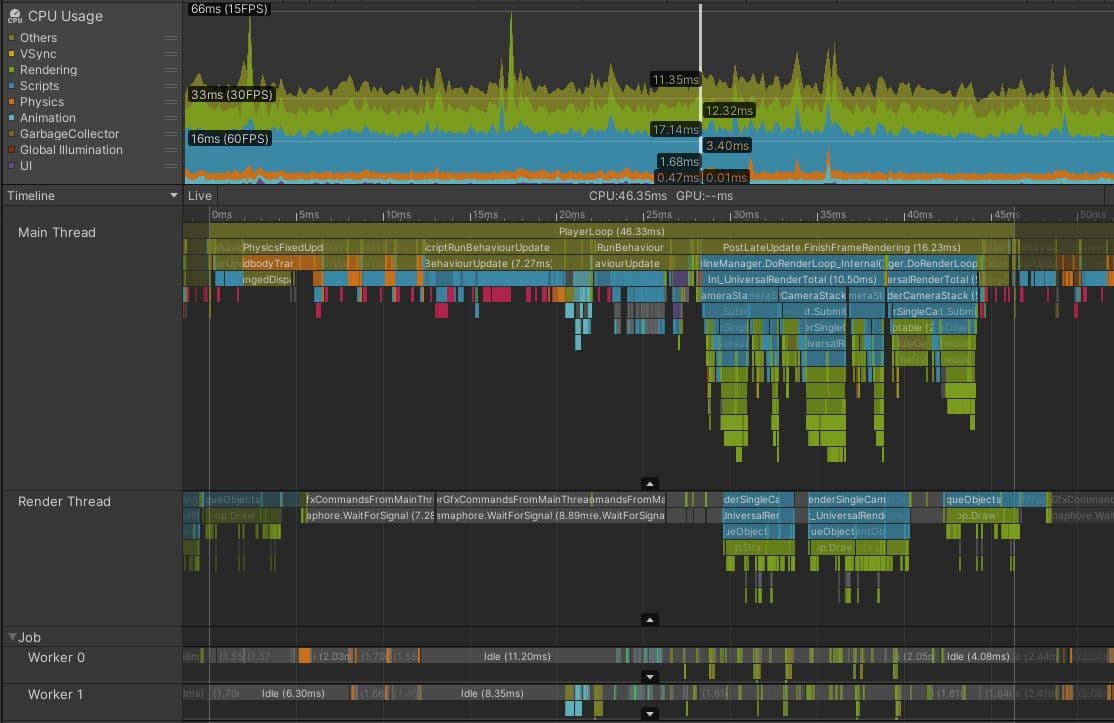

L'image ci-dessus montre un jeu fonctionnant confortablement dans le budget de trame de ~22 ms requis pour 30 FPS. Notez le temps d'attente de WaitForTargetfps du thread principal jusqu'à VSync et les temps d'inactivité gris dans le thread de rendu et le thread de travail. Notez également que l'intervalle VBlank peut être observé en regardant les temps de fin de Gfx.Present trame par trame, et que vous pouvez dessiner une échelle de temps dans la zone Timeline ou sur la règle de temps en haut pour mesurer d'une de ces à la suivante.

Si votre jeu n'est pas dans le budget de trame du CPU, la prochaine étape est d'enquêter sur quelle partie du CPU est le goulet d'étranglement – en d'autres termes, quel thread est le plus occupé.

Il est rare que l'ensemble de la charge de travail du CPU soit le goulot d'étranglement. Les CPU modernes ont un certain nombre de cœurs différents, capables d'effectuer un travail de manière indépendante et simultanée. Différents threads peuvent s'exécuter sur chaque cœur de CPU. Une application Unity complète utilise une gamme de threads pour différents objectifs, mais ceux qui sont les plus courants pour trouver des problèmes de performance sont :

Un exemple du monde réel d'optimisation du thread principal

L'image ci-dessous montre à quoi cela pourrait ressembler dans un projet qui est limité par le thread principal. Ce projet fonctionne sur un Meta Quest 2, qui cible normalement des budgets de trame de 13,88 ms (72 fps) ou même 8,33 ms (120 fps), car des taux de trame élevés sont importants pour éviter le mal des transports dans les appareils VR. Cependant, même si ce jeu visait 30 fps, il est clair que ce projet est en difficulté.

Bien que le thread de rendu et les threads de travail ressemblent à l'exemple qui est dans le budget de trame, le thread principal est clairement occupé par le travail pendant toute la trame. Même en tenant compte de la petite quantité de surcharge du profileur à la fin de la trame, le thread principal est occupé pendant plus de 45 ms, ce qui signifie que ce projet atteint des taux de trame inférieurs à 22 fps. Il n'y a pas de marqueur qui montre le thread principal attendant idlement VSync ; il est occupé pendant tout le cadre.

La prochaine étape de l'enquête consiste à identifier les parties du cadre qui prennent le plus de temps et à comprendre pourquoi c'est le cas. Sur ce cadre, PostLateUpdate.FinishFrameRendering prend 16,23 ms, plus que le budget total du cadre. Un examen plus approfondi révèle qu'il y a cinq instances d'un marqueur appelé Inl_RenderCameraStack, indiquant que cinq caméras sont actives et rendent la scène. Puisque chaque caméra dans Unity invoque l'ensemble du pipeline de rendu, y compris le culling, le tri et le batching, la tâche de la plus haute priorité pour ce projet est de réduire le nombre de caméras actives, idéalement à une seule.

BehaviourUpdate, le marqueur Profiler qui englobe toutes les exécutions de la méthode MonoBehaviour.Update(), prend 7,27 millisecondes dans ce cadre.

Dans la vue Timeline, les sections de couleur magenta indiquent les points où les scripts allouent de la mémoire gérée sur le tas. En passant à la vue Hierarchy, et en filtrant en tapant GC.Alloc dans la barre de recherche, on voit que l'allocation de cette mémoire prend environ 0,33 ms dans ce cadre. Cependant, c'est une mesure inexacte de l'impact que les allocations de mémoire ont sur les performances de votre CPU.

Les marqueurs GC.Alloc ne sont pas chronométrés en enregistrant un point de début et de fin comme des échantillons Profiler typiques. Pour minimiser leur surcharge, Unity enregistre uniquement l'horodatage de l'allocation et la taille allouée.

Le Profiler attribue une petite durée d'échantillon artificielle aux marqueurs GC.Alloc uniquement pour s'assurer qu'ils sont visibles dans les vues Profiler. L'allocation réelle peut prendre plus de temps, surtout si une nouvelle plage de mémoire doit être demandée au système. Pour voir l'impact plus clairement, placez des marqueurs Profiler autour du code qui effectue l'allocation ; dans le profilage approfondi, les écarts entre les échantillons GC.Alloc de couleur magenta dans la vue Timeline fournissent une indication de combien de temps ils pourraient avoir pris.

De plus, allouer de la nouvelle mémoire peut avoir des effets négatifs sur les performances qui sont plus difficiles à mesurer et à attribuer directement :

Au début du cadre, quatre instances de Physics.FixedUpdate s'additionnent à 4,57 ms. Plus tard, LateBehaviourUpdate (appels à MonoBehaviour.LateUpdate()) prennent 4 ms, et Animators représentent environ 1 ms. Pour s'assurer que ce projet respecte son budget et son taux de cadre souhaités, tous ces problèmes de thread principal doivent être examinés pour trouver des optimisations appropriées.

Pièges courants pour le goulet d'étranglement du thread principal

Les plus grands gains de performance seront réalisés en optimisant les choses qui prennent le plus de temps. Les domaines suivants sont souvent des endroits fructueux à explorer pour optimiser dans des projets liés au thread principal :

Lisez nos guides d'optimisation qui offrent une longue liste de conseils pratiques pour optimiser certains des pièges les plus courants :

Selon le problème que vous souhaitez examiner, d'autres outils peuvent également être utiles :

Pour des conseils complets sur l'optimisation de votre jeu, téléchargez gratuitement ces guides d'experts Unity :

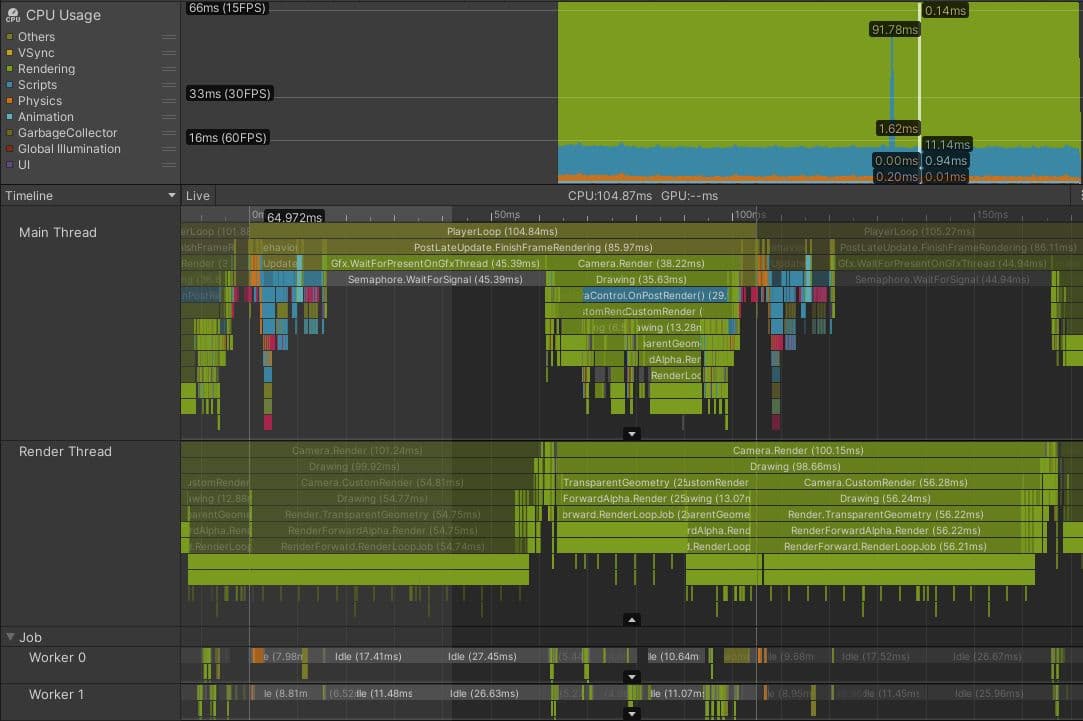

Voici un projet réel qui est lié à son thread de rendu. C'est un jeu de console avec un point de vue isométrique et un budget de temps d'image cible de 33,33 ms.

La capture du Profiler montre qu'avant que le rendu puisse commencer sur l'image actuelle, le thread principal attend le thread de rendu, comme indiqué par le marqueur Gfx.WaitForPresentOnGfxThread . Le thread de rendu soumet encore des commandes d'appel de dessin de l'image précédente et n'est pas prêt à accepter de nouveaux appels de dessin du thread principal ; il passe également du temps dans Camera.Render.

Vous pouvez faire la différence entre les marqueurs relatifs à l'image actuelle et les marqueurs d'autres images, car ces derniers apparaissent plus sombres. Vous pouvez également voir qu'une fois que le thread principal est capable de continuer et de commencer à émettre des appels de dessin pour que le thread de rendu les traite, le thread de rendu prend plus de 100 ms pour traiter l'image actuelle, ce qui crée également un goulot d'étranglement lors de l'image suivante.

Une enquête plus approfondie a montré que ce jeu avait une configuration de rendu complexe, impliquant neuf caméras différentes et de nombreux passages supplémentaires causés par des shaders de remplacement. Le jeu rendait également plus de 130 lumières ponctuelles en utilisant un chemin de rendu avant, ce qui peut ajouter plusieurs appels de dessin transparents supplémentaires pour chaque lumière. Au total, ces problèmes combinés ont créé plus de 3000 appels de dessin par image.

Pièges courants pour les goulots d'étranglement du thread de rendu

Les causes suivantes sont courantes à examiner pour les projets liés au thread de rendu :

Le module Profiler de rendu montre un aperçu du nombre de lots d'appels de dessin et d'appels SetPass à chaque image. Le meilleur outil pour enquêter sur les lots d'appels de dessin que votre thread de rendu émet au GPU est le Débogueur de trame.

Outils pour résoudre les goulets d'étranglement identifiés

Bien que l'accent de cet e-book soit mis sur l'identification des problèmes de performance, les deux guides complémentaires d'optimisation des performances que nous avons précédemment mis en avant offrent des suggestions sur la façon de résoudre les goulets d'étranglement, selon que votre plateforme cible est PC ou console ou mobile. Dans le contexte des goulets d'étranglement du thread de rendu, il convient de souligner qu'Unity propose différents systèmes et options de regroupement en fonction des problèmes que vous avez identifiés. Voici un aperçu rapide de certaines des options que nous expliquons plus en détail dans les e-books :

De plus, du côté CPU, des techniques telles que Camera.layerCullDistances peuvent être utilisées pour réduire le nombre d'objets envoyés au thread de rendu en éliminant les objets en fonction de leur distance par rapport à la caméra, aidant à atténuer les goulets d'étranglement CPU lors du culling de la caméra.

Ce ne sont là que quelques-unes des options disponibles. Chacune d'entre elles a des avantages et des inconvénients différents. Certaines sont limitées à certaines plateformes. Les projets doivent souvent utiliser une combinaison de plusieurs de ces systèmes et, pour ce faire, il est nécessaire de comprendre comment en tirer le meilleur parti.

Les projets liés à des threads CPU autres que les threads principaux ou de rendu ne sont pas si courants. Cependant, cela peut se produire si votre projet utilise le Data-Oriented Technology Stack (DOTS), surtout si le travail est déplacé du thread principal vers des threads de travail utilisant le système de tâches.

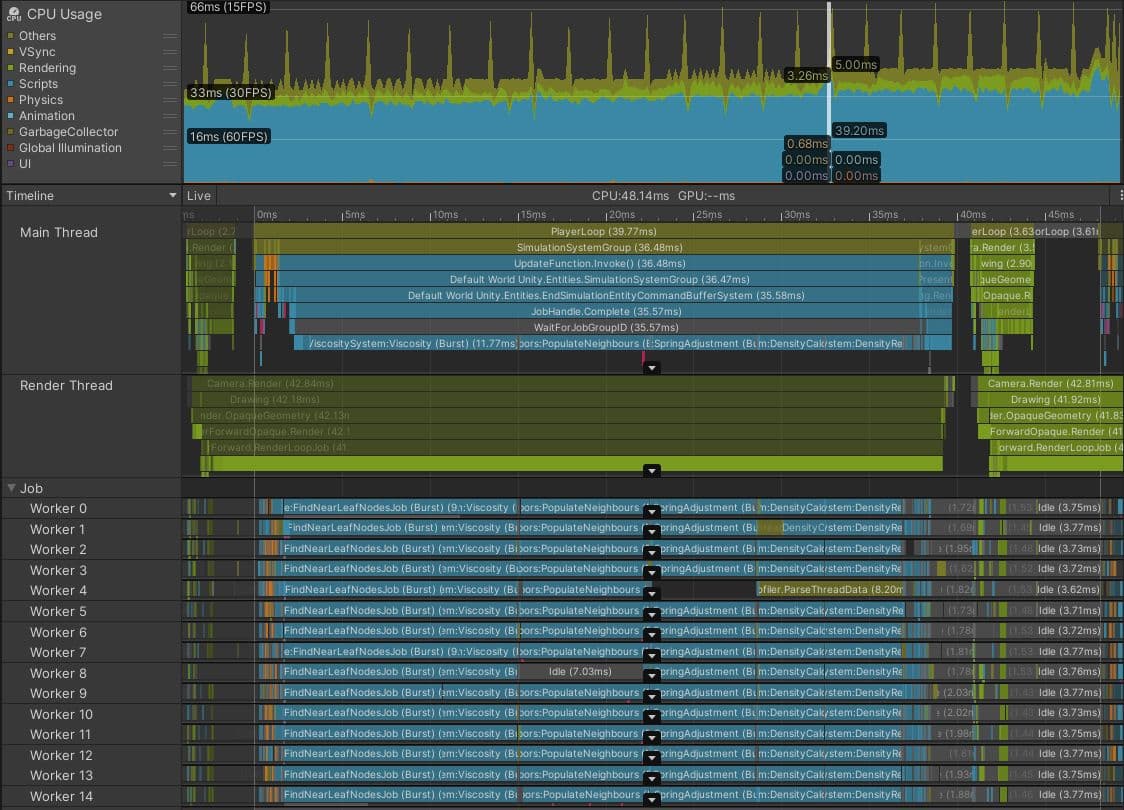

L'image ci-dessus est une capture du mode Play dans l'éditeur, montrant un projet DOTS exécutant une simulation de fluide de particules sur le CPU.

Cela ressemble à un succès à première vue. Les threads de travail sont étroitement regroupés avec des Burst-compiled tâches, indiquant qu'une grande quantité de travail a été déplacée du thread principal. En général, c'est une décision judicieuse.

Cependant, dans ce cas, le temps de trame de 48,14 ms et le marqueur gris WaitForJobGroupID de 35,57 ms sur le thread principal sont des signes que tout ne va pas bien. WaitForJobGroupID indique que le thread principal a planifié des tâches à exécuter de manière asynchrone sur des threads de travail, mais il a besoin des résultats de ces tâches avant que les threads de travail aient terminé de les exécuter. Les marqueurs bleus du Profiler sous WaitForJobGroupID montrent le thread principal exécutant des tâches pendant qu'il attend, dans une tentative de s'assurer que les tâches se terminent plus tôt.

Bien que les tâches soient compilées avec Burst, elles effectuent toujours beaucoup de travail. Peut-être que la structure de requête spatiale utilisée par ce projet pour trouver rapidement quelles particules sont proches les unes des autres devrait être optimisée ou remplacée par une structure plus efficace. Ou, les tâches de requête spatiale peuvent être planifiées pour la fin de la trame plutôt qu'au début, les résultats n'étant pas requis avant le début de la prochaine trame. Peut-être que ce projet essaie de simuler trop de particules. Une analyse plus approfondie du code des tâches est nécessaire pour trouver la solution, donc ajouter des marqueurs de Profiler plus fins peut aider à identifier leurs parties les plus lentes.

Les tâches de votre projet ne sont peut-être pas aussi parallélisées que dans cet exemple. Peut-être que vous avez juste une longue tâche s'exécutant dans un seul thread de travail. C'est acceptable, tant que le temps entre la planification de la tâche et le moment où elle doit être terminée est suffisamment long pour que la tâche puisse s'exécuter. Si ce n'est pas le cas, vous verrez le thread principal se bloquer en attendant que la tâche se termine, comme dans la capture d'écran ci-dessus.

Pièges courants pour les goulets d'étranglement des threads de travail

Les causes courantes des points de synchronisation et des goulets d'étranglement des threads de travail incluent :

Vous pouvez utiliser la fonction Flow Events dans la vue Timeline du module Profiler d'utilisation du CPU pour enquêter sur le moment où les travaux sont planifiés et quand leurs résultats sont attendus par le thread principal.

Pour plus d'informations sur l'écriture de code DOTS efficace, consultez le guide DOTS Best Practices.

Votre application est limitée par le GPU si le thread principal passe beaucoup de temps dans des marqueurs de Profiler comme Gfx.WaitForPresentOnGfxThread, et votre thread de rendu affiche simultanément des marqueurs comme Gfx.PresentFrame ou .WaitForLastPresent.

La meilleure façon d'obtenir les temps de trame GPU est d'utiliser un outil de profilage GPU spécifique à la plateforme cible, mais tous les appareils ne facilitent pas la capture de données fiables.

L'API FrameTimingManager peut être utile dans ces cas, fournissant des temps de trame de haut niveau à faible surcharge à la fois sur le CPU et le GPU.

La capture ci-dessus a été réalisée sur un téléphone mobile Android utilisant l'API graphique Vulkan. Bien que certains des temps passés dans Gfx.PresentFrame dans cet exemple puissent être liés à l'attente de VSync, la longueur extrême de ce marqueur de Profiler indique que la majorité de ce temps est passée à attendre que le GPU termine le rendu de la trame précédente.

Dans ce jeu, certains événements de gameplay ont déclenché l'utilisation d'un shader qui a triplé le nombre d'appels de dessin rendus par le GPU. Les problèmes courants à enquêter lors du profilage des performances GPU incluent :

Si votre application semble être limitée par le GPU, vous pouvez utiliser le Débogueur de trames comme un moyen rapide de comprendre les lots d'appels de dessin envoyés au GPU. Cependant, cet outil ne peut pas présenter d'informations spécifiques sur le timing du GPU, seulement comment la scène globale est construite.

La meilleure façon d'examiner la cause des goulets d'étranglement du GPU est d'examiner une capture GPU d'un profileur GPU approprié. L'outil que vous utilisez dépend du matériel cible et de l'API graphique choisie. Voir la section des outils de profilage et de débogage dans l'e-book pour plus d'informations.

Trouvez plus de meilleures pratiques et conseils dans le centre des meilleures pratiques Unity. Choisissez parmi plus de 30 guides, créés par des experts de l'industrie, ainsi que par des ingénieurs et artistes techniques de Unity, qui vous aideront à développer efficacement avec les outils et systèmes de Unity.